ความแม่นในการวัด (Measurement Accuracy): สิ่งที่ผู้เชี่ยวชาญด้านมาตรวิทยาควรรู้

ความแม่นในการวัด (Measurement Accuracy): สิ่งที่ผู้เชี่ยวชาญด้านมาตรวิทยาควรรู้

ความแม่น (Accuracy)

ในทางมาตรวิทยา หมายถึงความใกล้เคียงของการเป็นไปตามกันระหว่างค่าปริมาณที่วัดได้ค่าหนึ่งกับค่าปริมาณจริงของสิ่งที่เจตนาวัด

เป็นปัจจัยสำคัญที่ไม่อาจมองข้าม 🔍 วันนี้ขอมาแชร์ความรู้เกี่ยวกับประเภทของความแม่นในการวัด ที่ทุกคนในวงการมาตรวิทยาควรทราบ

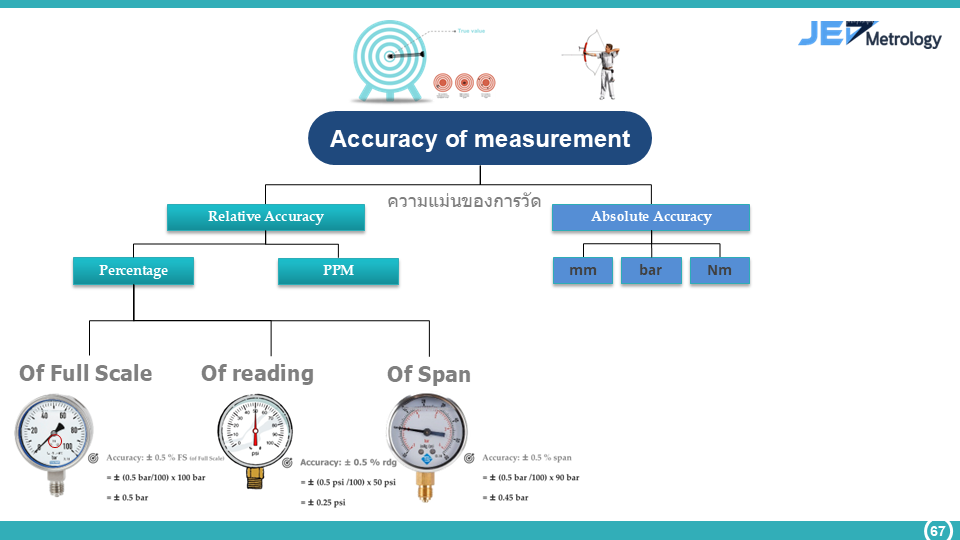

📊 ความแม่นแบ่งออกเป็น 2 ประเภทหลัก:

ได้แก่ ความแม่นสัมพัทธ์ (Relative Accuracy) และความแม่นสัมบูรณ์ (Absolute Accuracy)

ความแม่นสัมพัทธ์ (Relative Accuracy)

ความแม่นสัมพัทธ์ (Relative Accuracy)

แสดงในรูปแบบอัตราส่วนหรือเปอร์เซ็นต์ ประกอบด้วย:

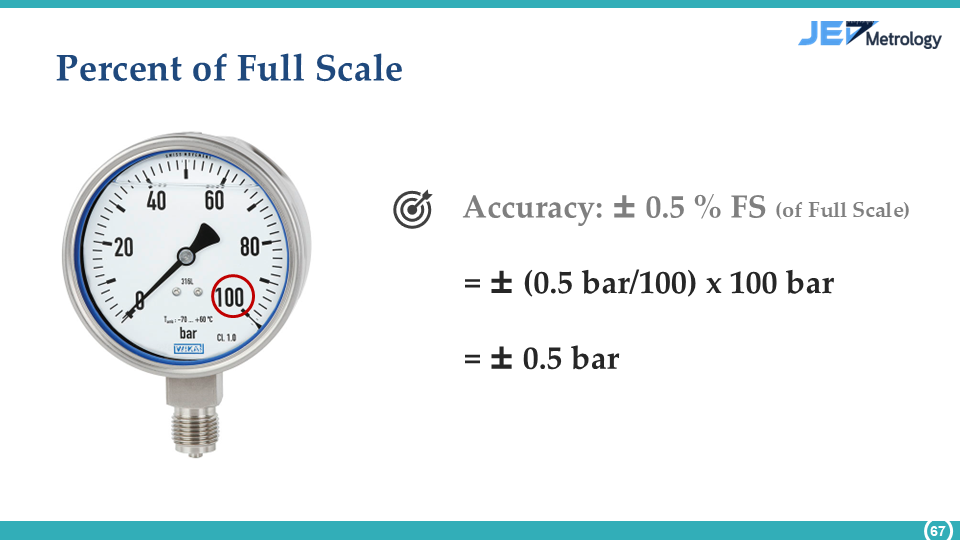

1.1 %FS (Full Scale): อ้างอิงกับพิสัยเต็ม

💡 Example: เครื่องวัด 0-100 bar, ±0.5%FS = ความคลาดเคลื่อน ±0.5 bar

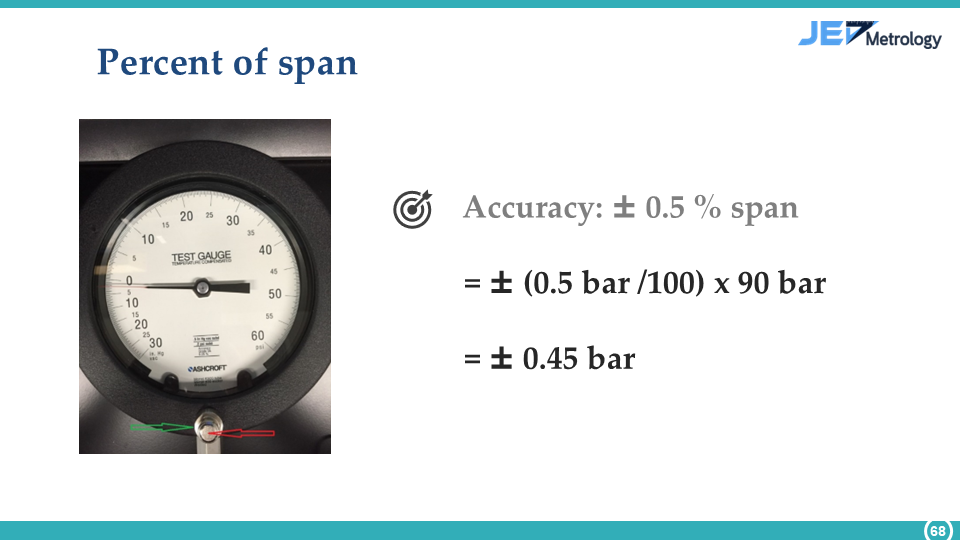

1.2 %span: อ้างอิงกับช่วงการวัด

💡 Example: ช่วงวัด 90 bar, ±0.5%span = ความคลาดเคลื่อน ±0.45 bar

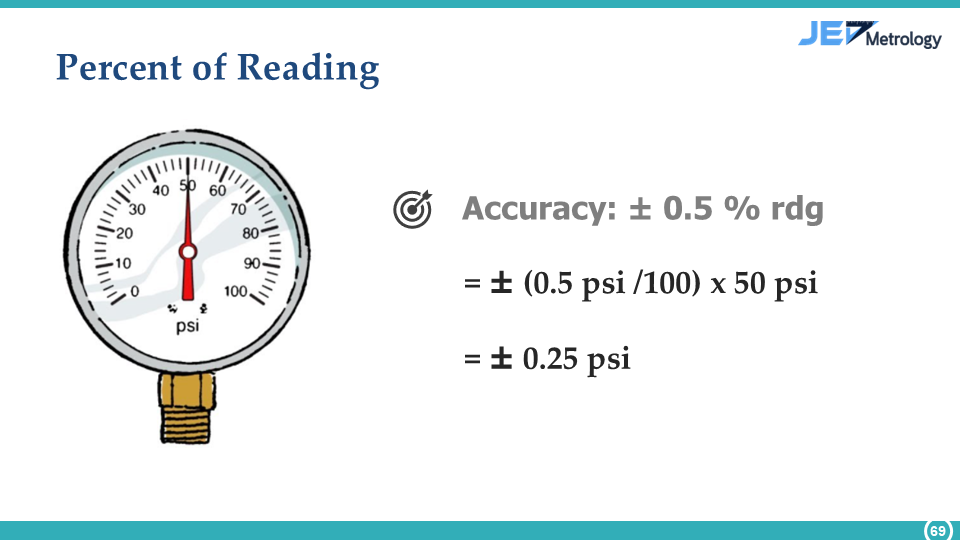

1.3 %rdg (Reading): อ้างอิงกับค่าที่อ่านได้

💡 Example: อ่านค่า 50 psi, ±0.5%rdg = ความคลาดเคลื่อน ±0.25 psi

สำหรับการวัดที่ต้องการความละเอียดสูงมาก:

ความแม่นสัมบูรณ์ (Absolute Accuracy)

ความแม่นสัมบูรณ์ (Absolute Accuracy)

แสดงในหน่วยวัดโดยตรง เช่น:

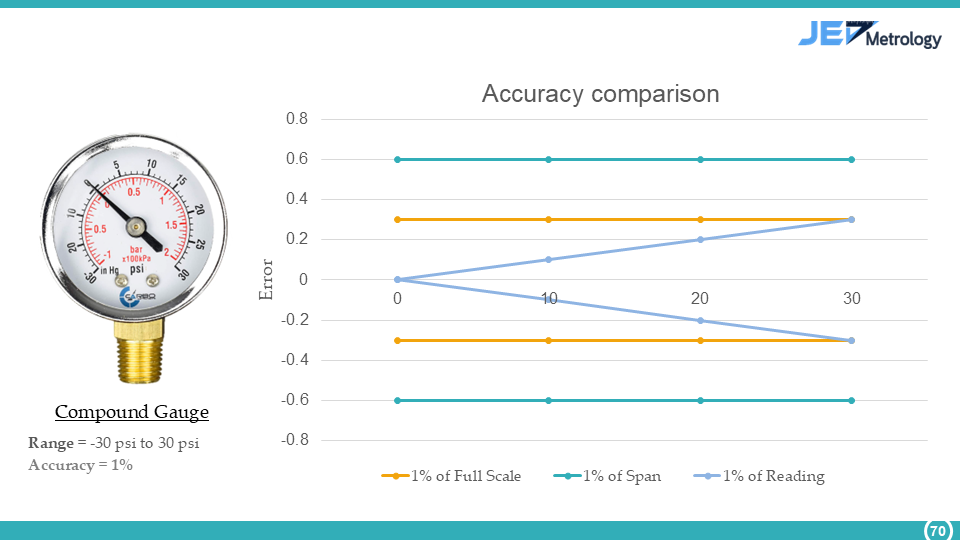

📈 การเปรียบเทียบความแม่นในการวัด - กรณีศึกษา Compound Gauge

1% of Reading (rdg)

1% of Reading (rdg)